Impostazione orizzontale: distinguersi dalla competizione nel panorama internazionale

L'Unione europea ha optato per un quadro giuridico orizzontale nel suo approccio alla legislazione sull'intelligenza artificiale. Il quadro giuridico dell'Unione europea in materia di intelligenza artificiale adotta una prospettiva intersettoriale ed è meticolosamente concepito, con quasi un centinaio di articoli.

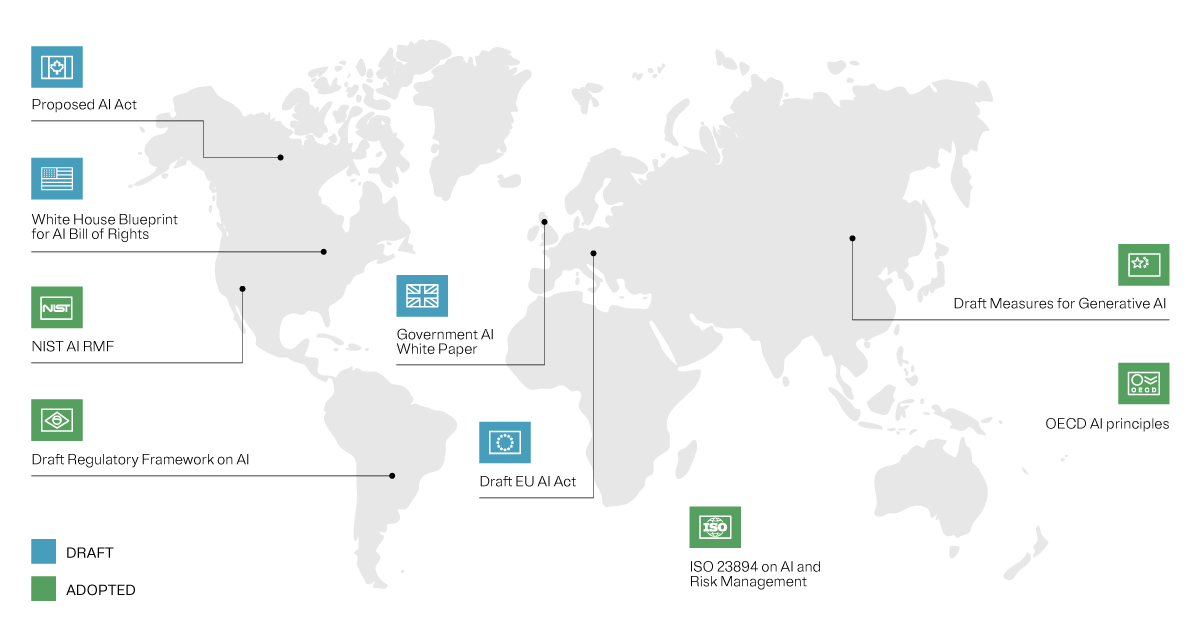

Nel presente articolo scoprirai maggiori informazioni sulla legge dell'Unione europea sull'intelligenza artificiale. Questa legislazione non è solo la prima del suo genere, ma anche un punto di riferimento per la regolamentazione internazionale dell'intelligenza artificiale, progettata per creare un precedente in un panorama dell'IA in rapida evoluzione.

Proteggere i valori e favorire l'innovazione

La legge dell'Unione europea sull'intelligenza artificiale è attentamente equilibrata. Non si tratta solo di creare una rete di sicurezza per la società, l'economia, i valori e i diritti fondamentali europei che potrebbero essere minacciati dai sistemi di IA, ma è anche un chiaro segno del potere e del potenziale dell'innovazione dell'IA, con salvaguardie integrate per incoraggiare e proteggere i suoi progressi. Il testo cerca di trovare un equilibrio tra la gestione del rischio e la protezione delle infrastrutture critiche da potenziali pericoli, incoraggiando allo stesso l'innovazione che l'intelligenza artificiale per finalità generali può apportare.

La creazione di questa legge è stata tutt'altro che facile e la definizione di ''intelligenza artificiale'' è stata uno degli aspetti più controversi. Da quando è stata proposta per la prima volta nell'aprile del 2021, la legge è ha subito numerose iterazioni, dove ogni emendamento rifletteva la fluidità del dibattito sull'intelligenza artificiale e il suo impatto sulla società.

Al trilogo di dicembre, Francia, Germania e Italia hanno sollevato preoccupazioni sulle limitazioni poste a potenti modelli di IA e hanno provato a proporre un regime normativo più leggero per modelli come GPT-4 di OpenAI.

Dopo molte discussioni, il compromesso raggiunto dalla Commissione UE è stato quello di adottare un approccio graduale, con regole di trasparenza orizzontali per tutti i modelli e obblighi aggiuntivi per i modelli a rischio sistemico.

A che punto è la legge?

Il 2 febbraio 2024, il Comitato dei rappresentanti permanenti ha votato per sostenere l'accordo politico raggiunto nel dicembre 2023. Il 13 marzo, il Parlamento ha votato per approvare la legge, con 523 voti a favore, 46 contro e 49 astensioni.

La legge sull'intelligenza artificiale è entrata in vigore 20 giorni dopo la sua pubblicazione sulla Gazzetta ufficiale dell'Unione europea. Le disposizioni sui sistemi vietati sono stati applicati dopo sei mesi e gli obblighi per i fornitori di IA per finalità generali devono essere applicati dopo 12 mesi. La maggior parte degli altri requisiti verrà applicata dopo due anni.

I sistemi ad alto rischio destinati a essere utilizzati come componenti di sicurezza di un prodotto o coperti da altre normative nell'UE hanno 36 mesi di tempo per conformarsi alla legge.

Analisi del concetto di ''intelligenza artificiale''

Originariamente, la legge definiva l'apprendimento automatico, la base dei sistemi di IA, come comprendente ''l'apprendimento supervisionato, non supervisionato e per rinforzo, utilizzando una varietà di metodi, compreso l'apprendimento profondo''. Il testo ora include una definizione aggiornata che definisce i sistemi di IA come ''sistemi basati su macchine che sono progettati per operare con vari gradi di autonomia e che possono mostrare capacità di adattamento dopo l'implementazione, e che, per scopi espliciti o impliciti, ragionano a partire da input per produrre output come previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali''.

La complessità dei sistemi di IA è una scala progressiva, con sistemi più complessi che richiedono una potenza di calcolo e dati di input significativi. L'output di questi sistemi può essere semplice o estremamente complesso, a seconda della sofisticazione dell'IA in questione.

Questa ampia definizione copre una vasta gamma di tecnologie, dai chatbot più comuni ai modelli di IA generativa altamente sofisticati. Tuttavia, è importante sottolineare il fatto che non tutti i sistemi di IA che rientrano in questa definizione verranno regolamentati. La legge utilizza un approccio basato sul rischio, includendo nel proprio quadro normativo solo i sistemi associati a rischi specifici. Calibrata in base al rischio

Regolamentazione dell'IA: calibrata in base al rischio

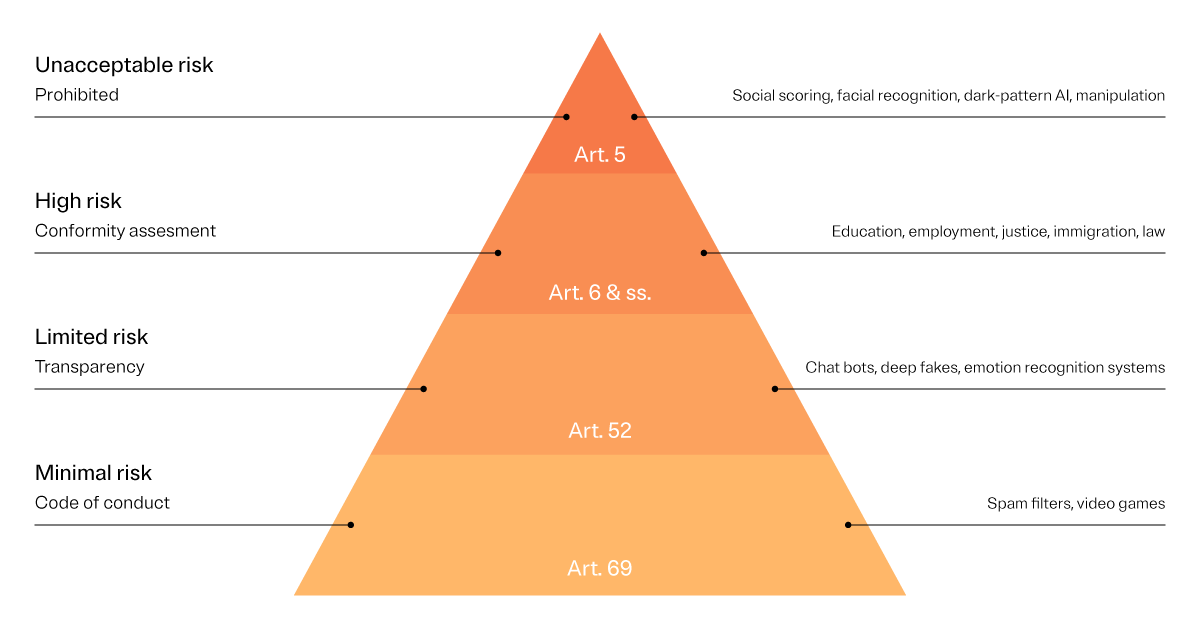

Qui le cose si fanno interessanti. La legge dell'Unione europea sull'intelligenza artificiale ha diversi ''contenitori'' per diversi sistemi di IA. Alcuni sono considerati come un rischio inaccettabile per i valori europei, il che comporta il loro divieto. I sistemi ad alto rischio, anche se non vietati, devono rispettare regolamenti più rigorosi. È fondamentale ricordare che queste categorie di rischio non sono statiche. Infatti, la legge è ancora soggetta a modifiche e pertanto anche queste categorie potrebbero cambiare.

Livelli di rischio della legge dell'UE sull'IA

La legge dell'Unione europea sull'intelligenza artificiale definisce più livelli di rischio ammissibile: alto, limitato e rischio.

Questi sono i livelli di ''rischio accettabile'' che le organizzazioni possono tollerare, mentre il ''rischio inaccettabile'' è un livello di rischio che non può essere accettato e le organizzazioni devono modificare i loro modelli di conseguenza.